*Originalmente publicado en The Crypto Legal.

Principios Éticos y Herramientas regulatorias para la gobernanza de la IA

Como señalamos en la primera parte de este artículo, es necesario que en el Perú se de un primer paso para la construcción de un marco normativo que promueva el desarrollo ético de la inteligencia artificial (IA). A continuación, detallamos el estado actual de los principios ético para la IA y las herramientas regulatorias que tenemos a nuestra disposición.

Principios Éticos para la IA

Los países y entidades supranacionales que lideran el desarrollo de esta tecnología (Estados Unidos1 y China2) y quienes buscan ponerse al día con ellos (Unión Europea3 y Corea del Sur4) ya han establecido un marco ético para la IA, pero no existe uniformidad en el alcance o el contenido de los principios que han establecido (como se muestra en la tabla N° 1).

| Actor | Principios | Reconocimiento |

| Estados Unidos | -Responsabilidad humana -Equidad -Trazabilidad -Confiabilidad -Gobernabilidad | -Evitar sesgos -Transparencia -Seguridad -Robustez -Evitar daños no intencionados |

| China | -Armonía y amistad -Equidad y Justicia -Inclusión y compartición -Respeto a la privacidad -Seguridad y control -Responsabilidad compartida -Colaboración abierta -Gobernanza ágil | -Seguridad social -Respeto de DDHH -Igualdad de oportunidades -Eliminación de sesgos -Eliminación de discriminación. -Evitar monopolio de datos. -Confianza -Explicabilidad |

| Unión Europea | -Respeto a la autonomía humana -Prevención del daño -Justicia -Explicabilidad | -Agencia humana y supervisión -Robustez técnica y seguridad -Privacidad y gobernanza de los datos -Transparencia y justicia -Diversidad y no discriminación -Bienestar social y de medioambiente -Rendición de cuentas |

| Corea del Sur | -Mejorar la calidad de la vida humana. -No dañar a las personas. -Seguir las intenciones humanas | -Cooperación con las personas. -Protección del derecho y la moralidad -Requerir confirmación de intención humana |

A pesar de sus diferencias, en la tabla también se puede observar que comparten varias similitudes en su contenido. En esa línea, Fjeld y otros (2020)5 identificaron los 8 temas más comunes en la definición de principios éticos para la IA de una revisión de 36 documentos elaborados por gobiernos, empresas, ONGs y organizaciones intergubernamentales. Estos son:

- Privacidad: La IA debe respetar la privacidad individual, tanto en el uso de los datos como su impacto en la agencia que tienen las personas sobre sus datos. Inclusiones representativas en este campo son el control sobre el uso de los datos y el requerir consentimiento.

- Rendición de Cuentas: Incluye los mecanismos para asegurar que la responsabilidad por la IA está distribuida apropiadamente con los remedios necesarios. Inclusiones representativas en este campo son la adopción de nuevas regulaciones, las evaluaciones de impacto y las auditorías a la IA.

- Protección y Seguridad: Los sistemas IA deben ser seguros, realizando actividades tal como se espera de ellos y resistentes ante terceros no autorizados. Inclusiones representativas en este campo son la seguridad como parte del diseño, así como la predictibilidad de los resultados.

- Transparencia y Explicabilidad: El diseño e implementación de la IA debe permitir su vigilancia y traducción a términos entendibles sobre cómo está siendo usada la información. Inclusiones representativas en este campo son el uso de algoritmos y datos open source y la notificación de que se está interactuando con una IA.

- Equidad y No discriminación: La IA debe promover la inclusión y maximizar la equidad. Inclusiones representativas en este campo son la prevención de sesgos, la inclusión en el diseño y en sus beneficios, así como la representación en datos de alta calidad.

- Control humano de la tecnología: Las decisiones importantes deben estar sujetas a la revisión humana. Inclusiones representativas en este campo son la habilidad de optar por no tomar decisiones automatizadas y poder hacer una revisión de las decisiones automatizadas.

- Responsabilidad profesional: Los individuos involucrados en el desarrollo de la IA deben actuar con profesionalismo e integridad. Inclusiones representativas en este campo son la colaboración con múltiples stakeholders y considerar sus efectos en el largo plazo.

- Promoción de los Valores Humanos: La IA debe promover el bienestar de la humanidad. Inclusiones representativas en este campo son el apalancamiento social y el acceso vía la educación a este tipo de tecnología.

Si bien éstos son los temas más comunes no necesariamente tienen que incluirse todos dentro de una fórmula nacional, ya que “los principios deben ser entendidos en su contexto cultural , lingüístico, geográfico y organizacional, algunos de estos temas serán más relevantes para un contexto particular o una audiencia que otra”6 (Fjeld et al., 2020, p.5).

Cuando se elijan estos principios se debe evitar vaguedades innecesarias que dificulten su cumplimiento y tratar de incorporar todos los principios que otras instituciones hayan elaborado, porque podría generarse una sobrecarga mental en las personas implicadas en proyectos de IA, al tratar de ajustar sus iniciativas a un número muy amplio de principios escasamente definidos, lo que haría esta labor más compleja y difícil en lugar de simplificarla.

Herramientas regulatorias e incentivos para su aplicación

Para velar por la implementación de los principios éticos en proyectos IA, necesitamos de herramientas que aterricen estos conceptos. En la actualidad, existen distintas herramientas que pueden utilizarse como las auditorías sobre el impacto en los DDHH, evaluaciones a las vulnerabilidades de seguridad, metodologías de gestión de riesgo, oficiales de cumplimiento de ética, sandbox regulatorios, entre otros.

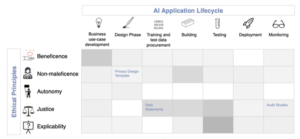

Sin embargo, en este campo aún hay mucho por trabajar. La mayoría de las herramientas aún se encuentra en desarrollo o no tienen evidencia empírica de su efectividad. Además, como señala (Morley, et al., 2019)7, estas herramientas se enfocan en las primeras fases del ciclo de la IA como son el desarrollo de casos de uso o la fase de diseño y entrenamiento de los datos, pero no tanto en las siguientes fases del ciclo como se muestra en la siguiente imagen.

A pesar de estas limitaciones, se pueden diseñar metodologías de trabajo personalizadas para los principios éticos que hayamos elegido y vincularlas con las herramientas regulatorias disponibles y las fases del ciclo de la IA. Por otro lado, hay que ser conscientes de que esta tarea requiere del apoyo de distintos actores, el estado, el sector privado y los ciudadanos. Lo que nos lleva a un último punto.

La IA puede mejorar nuestras vidas, pero debemos encauzar su despliegue

Tratar de establecer una moratoria a la IA dados los problemas éticos y legales señalados, es una política que tendrían un alto costo en el bienestar potencial de la población cómo puede ser la mejora en los servicios públicos, la mayor eficiencia de la administración pública o de la detección de crímenes de cuellos blanco como la corrupción o el lavado de activos.

Sin embargo, el marco normativo y el estado de cosas actual tampoco nos representan una situación favorable para la mayor parte de la población. Si la IA ha llegado para quedarse, debemos encauzarla. Para esto, un primer paso es complementar la Ley de Protección de Datos Personales y el Marco de Confianza Digital (D.U. 007-2020) con lo señalado sobre los principios éticos y las herramientas regulatorias para la IA, así como incorporar de forma expresa a la IA como objeto de las políticas, planes o estrategias nacionales que desarrolle la Secretaría de Gobierno Digital con el apoyo activo de la ciudadanía, las iniciativas privadas de IA y la academia.

REFERENCIAS:

- Defense Innovation Board (2019). AI Principles: Recommendations on the Ethical Use of Artificial Intelligence by the Department of Defense. Recuperado el 20.06.20 de aquí ↩

- National New Generation Artificial Intelligence Governance Expert Committee (2019) Governance Principles for Responsible AI. Traducción de : 新一代人工智能治理原则——发展负责任的人工智能 Recuperado el 20.06.20 de: https://perma.cc/V9FL-H6J7 ↩

- High level Expert Group on Artificial Intelligence – Comisión Europea (2019) Ethics Guidelines for Trustworthy AI. Recuperado del 20.06.20 de aquí ↩

- Konrad-Adenauer-Stiftung (2019) Comparison of National Strategies to Promote Artificial Intelligence. Recuperado el 24.06.20 de aquí ↩

- Fjeld, J., Achten, N., Hilligoss, H., Nagy, A., y Srikumar, M. (2020) Principled Artificial Intelligence: Mapping Consensus in Ethical and Rights-based Approaches to Principles for AI. Berkman Klein Center for Internet & Society, Recuperado el 24.06.20 de:https://dash.harvard.edu/handle/1/42160420 ↩

- N. del T. Del inglés “Principles should be understood in their cultural, linguistic, geographic, and organizational context, and some themes will be more relevant to a particular context and audience than others” ↩

- Morley, J., Floridi, L., Kinsey, L., Elhalal, A. From What to How: An Initial Review of Publicly Available AI Ethics Tools, Methods and Research to Translate Principles into Practices arXiv preprint Recuperado el 24.06.20 de: https://arxiv.org/abs/1905.06876 ↩